这是一个非常好的问题,因为它触及了“人工智能”定义的核心。没有一个检验是“人工智能”本身,但我们可以用这些检验来评估一个系统是否表现出人工智能的特征。

下面我将列举几个著名的“检验”或“思想实验”,并分析它们如何帮助我们判断一个系统是否具有人工智能。

核心观点:区分“智能行为”与“真正的智能”

首先要明确,一个系统通过某个检验,只能说明它在该任务上表现出了智能行为,而不一定意味着它拥有真正的理解、意识或通用智能。

图灵测试

这是最著名、最经典的检验。

- 由艾伦·图灵在1950年提出,测试者通过文本与一个人类和一台机器进行匿名对话,如果测试者无法可靠地分辨出哪一个是机器,那么这台机器就通过了图灵测试。

- 目的:检验机器是否能在行为上与人类无法区分,从而判断其是否拥有“智能”。

- 是否具有人工智能:是,但这是对人工智能的早期定义。

- 支持观点:如果一个系统能流畅地、有逻辑地、甚至富有情感地与人对话,欺骗测试者,这无疑是高级人工智能(特别是自然语言处理)的体现。

- 局限性:

- 过于依赖语言:它只测试了对话能力,忽略了视觉、推理、创造力等其他智能维度。

- “鹦鹉学舌”问题:一个大型语言模型可能只是通过海量数据学习如何模仿人类对话模式,而并不真正“理解”对话的含义,它可能是一个完美的“模式匹配器”,而不是一个思考者。

- 标准模糊:如何定义“无法分辨”?是50%的概率,还是更高?

图灵测试是衡量对话型人工智能的一个经典(但已过时)的基准,像早期的聊天机器人ELIZA就曾短暂地“骗”过一些人,但显然不是AI,而像GPT-4这样的大模型,在很多情况下已经非常接近甚至通过了一个宽松的图灵测试。

勒纳特测试

这是对图灵测试的一个重要补充和修正。

- 由人工智能研究者史蒂夫·勒纳特提出,测试者可以向计算机系统提出一个需要常识推理才能回答的问题。“如果你把一支铅笔放进冰箱里,它会变成冰块吗?”一个有常识的系统会回答“不会”,因为它知道“铅笔”和“冰箱”的物理属性。

- 目的:检验机器是否拥有人类级别的常识和世界知识,而不仅仅是语言模仿能力。

- 是否具有人工智能:是的,这是对人工智能“理解能力”的更深层检验。

- 支持观点:能够进行常识推理是智能的核心,一个系统如果能理解物理世界的基本规则,说明它不仅仅在处理符号,而是在构建一个内部的知识模型。

- 挑战:建立一个完备的常识知识库极其困难,现代AI(如GPT系列)通过学习海量文本,学到了很多“常识”,但这种知识是统计关联的,而不是基于第一性原理的“理解”。

勒纳特测试比图灵测试更能衡量一个AI是否真正“理解”世界,而不仅仅是“会说话”。

中国房间思想实验

这是一个反对强人工智能的著名思想实验,由哲学家约翰·塞尔提出。

- 想象一个不懂中文的人被关在一个房间里,他有一本详细的规则手册(程序),外面的人从一个小窗口塞给他写有中文问题的纸条,他完全按照规则手册的指令,找到对应的符号,然后把这些符号作为答案递出去,对于外面的人来说,房间里的人似乎完美地理解中文并能流利回答,但实际上,房间里的人对中文一窍不通,他只是在机械地操作符号。

- 目的:反驳“语法等于语义”的观点,即,一个系统即使能完美地处理信息(语法),也并不意味着它能理解信息的含义(语义)。

- 是否具有人工智能:这个实验本身不是AI检验,而是一个论证工具,用来质疑当前AI是否具有真正的“理解力”或“心智”。

- 塞尔的结论:无论计算机程序多么复杂,它都只是在执行符号操作,没有真正的理解或意识,它永远无法实现“强人工智能”(具有人类般意识和理解的AI)。

- AI支持者的反驳:他们认为,当系统足够复杂时,符号操作本身就涌现出了理解力,房间里的人不是AI,AI是那本“规则手册”,当手册复杂到一定程度时,整个系统(规则+人+房间)就构成了理解。

中国房间不是一个检验,而是一场关于“什么是智能”的哲学辩论,它迫使我们思考:行为上的智能是否等同于内在的理解?

现代的AI能力检验

随着AI技术的发展,我们不再依赖单一的思想实验,而是通过一系列具体的任务来检验AI的能力。

- ImageNet挑战赛:检验AI在图像识别上的能力,AI需要准确识别图片中成千上万的物体,这个任务的极大成功,标志着计算机视觉领域的突破。

- AlphaGo战胜李世石:检验AI在复杂策略游戏上的能力,AlphaGo的胜利,特别是其走出许多“神之一手”,证明了AI不仅能计算,还能进行超越人类的直觉和创造性决策。

- GLUE/SuperGLUE基准测试:检验AI在自然语言理解上的综合能力,包括文本蕴含、情感分析、语义相似度等任务,这比单一的图灵测试更全面。

- 科学发现:检验AI在科学研究中的能力,DeepMind的AlphaFold2成功预测了几乎所有已知蛋白质的结构,解决了困扰生物学界50年的难题。

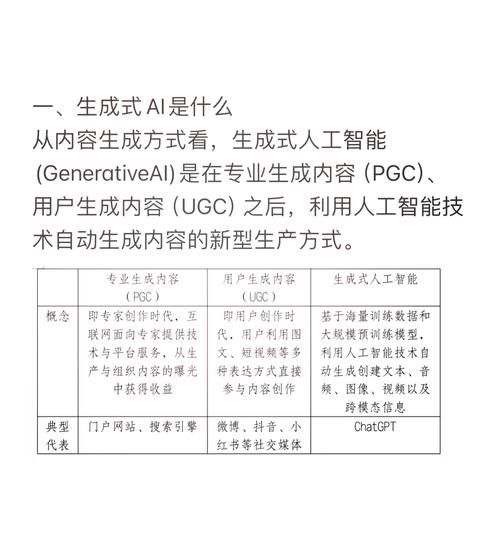

| 检验/测试 | 核心思想 | 衡量维度 | 是否是AI检验? |

|---|---|---|---|

| 图灵测试 | 能否在对话中模仿人类,让人无法分辨。 | 对话能力、语言流畅度 | 是,但侧重于行为模仿,是早期AI的基准。 |

| 勒纳特测试 | 能否回答需要常识推理的问题。 | 常识知识、世界模型 | 是,侧重于理解能力,比图灵测试更深一层。 |

| 中国房间 | 哲学思想实验,质疑符号操作是否等于理解。 | 内在意识、语义理解 | 不是,是一个哲学论证,用于挑战AI的本质。 |

| 现代AI任务 | 在特定领域(如图像、游戏、科学)超越人类。 | 专业任务性能、泛化能力 | 是,是当今衡量AI能力的实用标准。 |

最终答案:

没有一个单一的检验可以定义“人工智能”,但我们可以通过一系列检验来评估一个系统。

- 如果一个系统能通过图灵测试,说明它具有高级的对话式人工智能。

- 如果它能通过勒纳特测试,说明它具备了初步的常识推理能力。

- 如果它能在ImageNet或AlphaGo这样的任务中表现出色,说明它在特定领域拥有强大的人工智能能力。

而中国房间则提醒我们,即使AI通过了所有这些检验,关于它是否拥有真正的“理解”和“意识”的哲学辩论,可能永远不会有一个最终的答案。

标签: 人工智能检验标准定义 AI性能评估核心指标 人工智能质量衡量方法