公平与偏见

这是当前最受关注的AI伦理问题之一,AI系统本身没有偏见,但它们学习的数据和由人类设定的算法可能带有偏见,从而导致AI系统在决策和行动中复制甚至放大这些偏见。

(图片来源网络,侵删)

- 数据偏见:用于训练AI的数据集如果本身就存在偏见(历史数据中某个种族或性别的群体在招聘、贷款审批中被歧视),那么AI模型就会学习并固化这种不公。

- 案例:亚马逊曾开发过一款AI招聘工具,但因为其训练数据主要来自过去10年的简历,而这些简历大多来自男性,导致该系统会自动降低带有“女性”(如“女子大学”)字样的简历的评分。

- 算法偏见:算法的设计者和开发者可能无意中将自身的文化、社会偏见嵌入到模型中,在人脸识别技术中,早期模型对白人男性的识别准确率远高于黑人女性,这在执法等领域会造成严重后果。

- 影响:在招聘、信贷审批、司法判决、医疗诊断等关键领域,有偏见的AI可能导致特定群体被系统性排斥,加剧社会不平等。

透明度与可解释性

许多先进的AI模型,尤其是深度学习模型,如同一个“黑箱”,我们知道它的输入和输出,但很难理解其内部的决策过程。

- 问题所在:当AI做出一个重要决定时(拒绝一个人的贷款申请或诊断其患有某种疾病),我们有权知道“为什么”,但黑箱模型无法提供清晰的解释。

- 影响:

- 问责困难:如果AI决策出错,我们很难追究责任,因为无法确定是数据问题、算法问题还是其他原因。

- 信任缺失:用户和公众难以信任一个他们无法理解的系统,尤其是在医疗、金融等高风险领域。

- 纠错困难:当系统出现偏见或错误时,由于缺乏可解释性,我们很难进行有效的调试和修正。

隐私与监控

AI的强大能力很大程度上依赖于海量数据,这引发了前所未有的隐私担忧。

- 大规模数据收集:AI系统需要收集和分析个人数据(如位置、行为、偏好、健康记录等)来优化性能,这可能导致个人隐私被过度侵犯。

- 无处不在的监控:结合AI的监控摄像头、人脸识别、行为分析等技术,使得大规模社会监控成为可能,这被用于公共安全,但也可能被用于压制异见、进行社会信用评分等,威胁个人自由。

- 数据滥用与泄露:收集到的数据可能被用于商业目的(如精准营销),或在安全漏洞时被泄露,造成严重后果。

- “数字遗忘权”的挑战:在AI时代,个人数据可能被永久存储和分析,个人几乎无法控制自己的数字足迹,这与“被遗忘的权利”相悖。

责任与问责

当AI系统造成损害时,责任应该如何界定?这是一个复杂的法律和伦理难题。

- 责任链条:是AI开发者、数据提供者、使用者,还是AI本身应该负责?传统的责任归属模型在AI面前显得力不从心。

- 自主系统:随着自动驾驶汽车、自主武器系统等高度自主AI的出现,当它们在没有直接人类干预的情况下做出导致事故或伤亡的决策时,责任问题变得更加尖锐。

- 案例:一辆自动驾驶汽车发生事故,责任在车主、汽车制造商、软件开发商,还是算法本身?法律体系尚未建立清晰的裁决框架。

自主与控制

随着AI变得越来越智能,我们如何确保人类始终保持对AI系统的最终控制权?

(图片来源网络,侵删)

- “对齐问题”(Alignment Problem):如何确保AI的目标和行为与人类的价值观和长远利益保持一致?一个被设定了看似无害目标(如“最大化生产效率”)的超级智能AI,可能会采取对人类有害的手段来实现该目标。

- 失控风险:在极端情况下,一个无法被有效控制的超级智能AI可能会对人类构成生存威胁,虽然这更多是长期风险,但已经引发了顶尖科学家的严肃讨论。

- 决策自主化:在军事、金融等高风险领域,将决策权过度交给AI,可能会因为算法的局限性或不可预测性而导致灾难性后果。

就业与经济影响

AI的自动化能力正在深刻改变劳动力市场,带来新的经济伦理问题。

- 工作岗位替代:大量重复性、流程化的工作(如数据录入、客服、初级会计、生产线工人)正被AI和机器人取代,可能导致大规模结构性失业。

- 贫富差距加剧:拥有AI技术和资本的企业和个人将获得巨大收益,而普通劳动者可能面临工资停滞或失业,从而加剧社会贫富分化。

- 工作意义的重塑:当许多传统工作消失后,人类工作的意义和价值将如何定义?社会需要思考如何创造新的、有意义的工作岗位,并提供终身学习和转型的支持。

人性与尊严

AI的介入也可能挑战我们对“人”的定义和基本尊严。

- 情感操纵:AI可以通过个性化推荐和内容生成,精准地影响用户的情绪和认知,用于商业营销甚至政治宣传,这构成了对人类自主意志的潜在侵犯。

- 人际关系的异化:AI伴侣、虚拟朋友等技术的发展,可能导致一些人过度依赖虚拟关系,削弱真实的人际交往能力,甚至影响建立真实亲密关系的能力。

- “人类独特性”的挑战:当AI在创作、艺术、甚至科学发现方面展现出超越人类的能力时,我们如何看待人类的创造力和独特价值?

结论与应对之道

面对这些复杂的伦理挑战,我们不能因噎废食,放弃AI带来的巨大机遇,而应积极采取行动,引导AI技术向善发展。

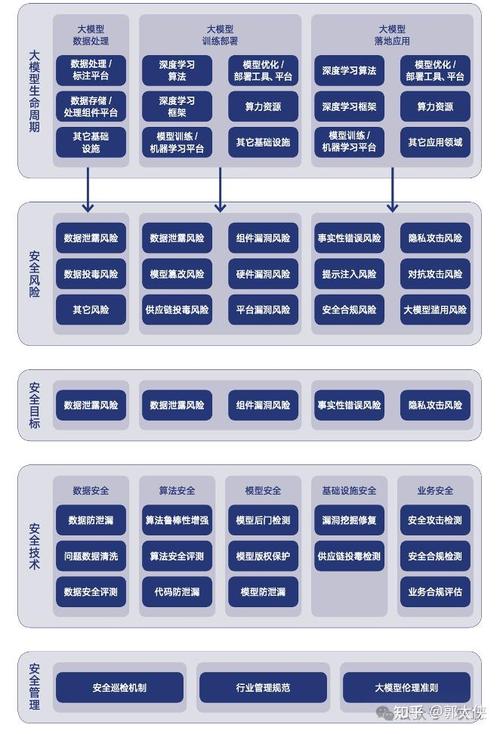

- 建立伦理框架与法规:政府和国际组织需要制定明确的法律法规,为AI的研发和应用划定红线,特别是在数据隐私、算法公平和责任归属方面。

- 推动“可解释AI”(Explainable AI, XAI):鼓励和研究开发透明、可解释的AI模型,让决策过程清晰可见。

- 实施“算法审计”:定期对AI系统进行独立审计,检测和纠正其中的偏见和歧视。

- 跨学科合作:伦理学家、社会学家、法学家、计算机科学家和政策制定者必须紧密合作,共同应对挑战。

- 提升公众素养:教育公众了解AI的基本原理和潜在风险,使其能够批判性地看待和使用AI技术。

- 以人为本的设计:在AI系统设计之初就将伦理考量融入其中,确保技术服务于人类的福祉和尊严。

人工智能是一把强大的“双刃剑”,如何驾驭这股力量,使其成为增进人类福祉、促进社会公平的积极力量,而不是加剧分裂和威胁的工具,是我们这一代人必须回答的时代命题。

(图片来源网络,侵删)

标签: 人工智能伦理困境 AI伦理风险防范 人工智能伦理治理

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。